Deepseek部署

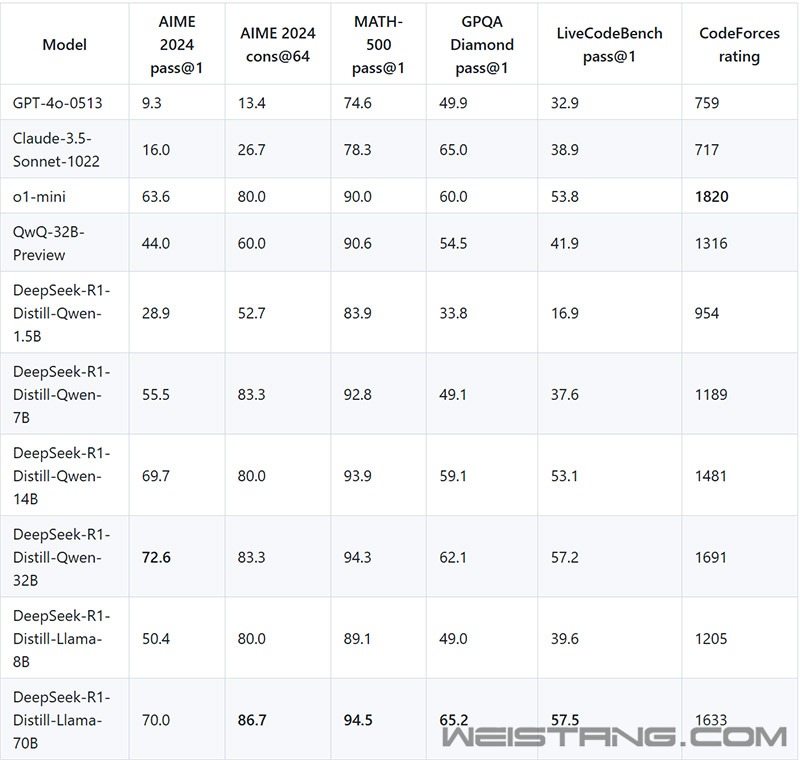

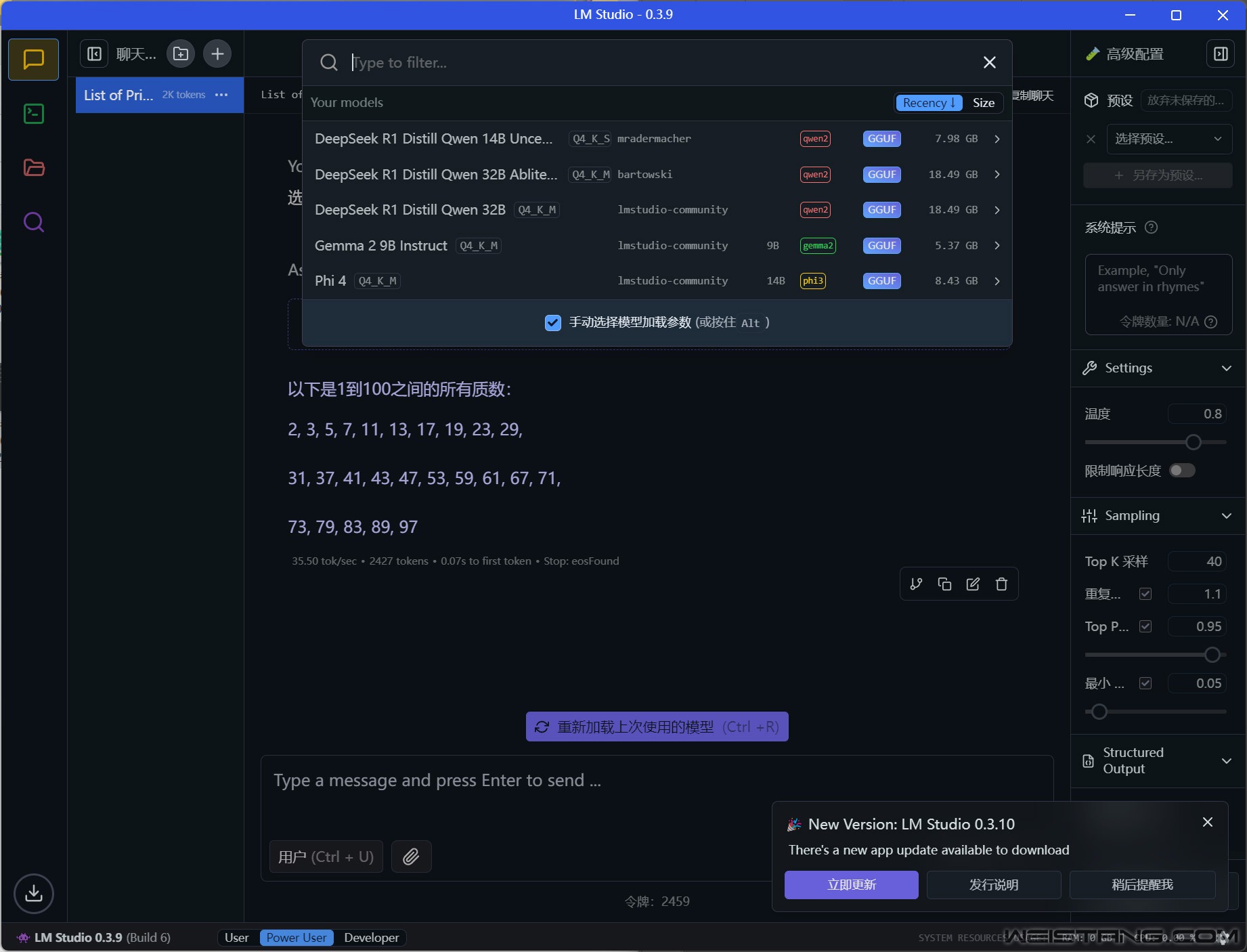

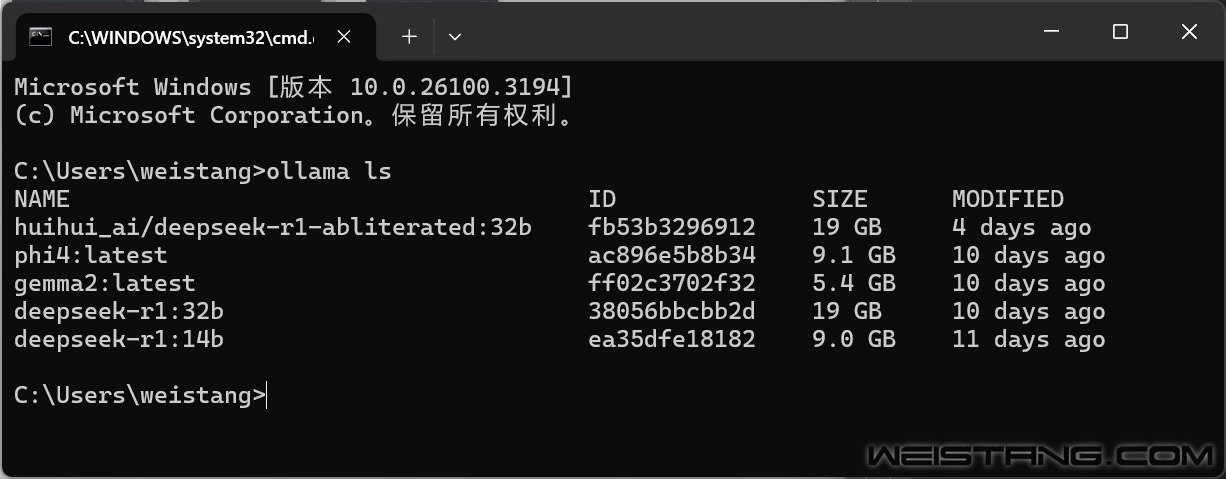

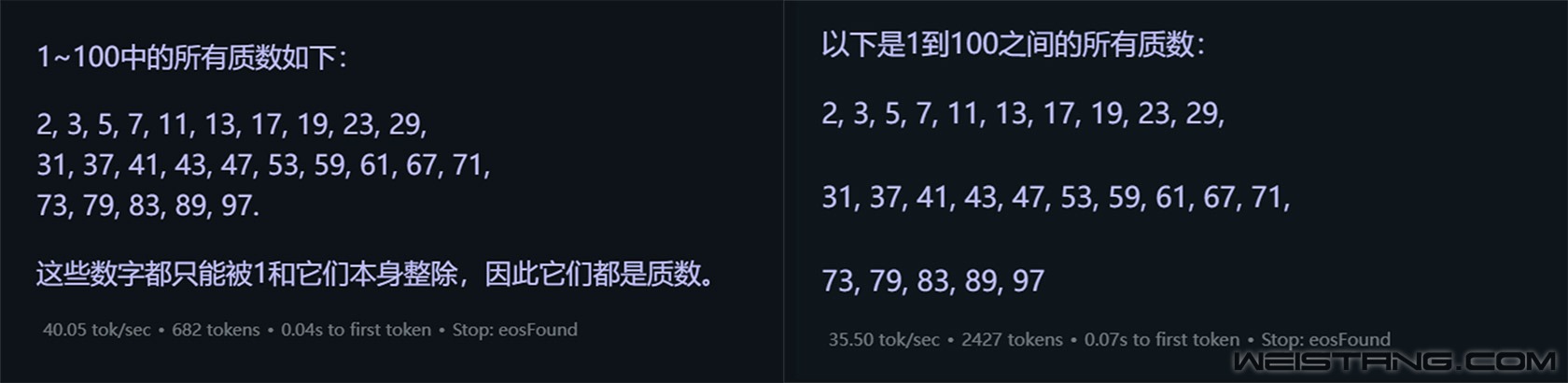

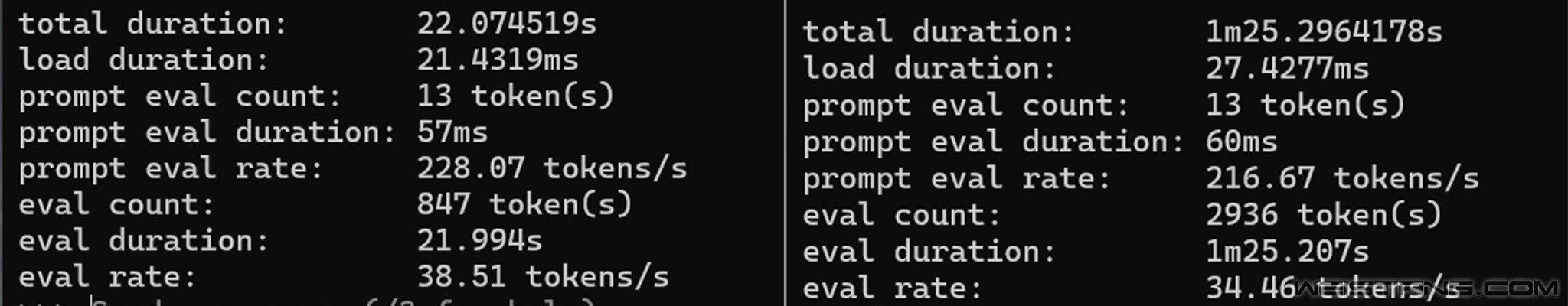

我们通过LM Studio和Ollama两个平台进行了部署,这里的建议就是如果你不需要联网,那么LM Studio更友好,并且可以配合AnythingLLM实现本地知识库, 简单易上手,如果部署后供多人建立本地知识库就更推荐Ollama+Page Assist+RAG Flow的组合,但后者相对部署更麻烦一点,win环境下需要通过WSL安装Doker来实现。  本地部署量力而行 个人玩家单卡的话推荐14B和32B的蒸馏模型 这里我们分别以两个平台为例进行简单测试,部署的模型为DeepSeek-14B的Qwen蒸馏模型,量化程度为Q4,模型文件和模型框架全部丢在KC3000 4TB SSD上,同时对比全部丢在4TB机械硬盘的情况(Win系统不在机械硬盘)。  LM Studio安装的部分模型容量  Ollama Studio安装的部分模型容量  左:KC3000 4TB 右:酷狼4TB  左:KC3000 4TB 右:酷狼4TB 能看到还是模型框架平台如果也在不同的硬盘上多少还是会带来一定的差异,尽管模型是Loading到内存,但对于通过Doker环境挂载知识库的情况很容易出现本地内存不足,特别是设置CPU负载占比较高的时候,需要调用硬盘的虚拟内存来作为缓存,此时平台的存储载体如果性能差异较大还是会带来输出令牌效率的差距,这个差距如果量化到GPU上来弥补,那可能成本就要远超过一张SSD的价格了。另外,在AI模型加载的时候也会有很明显的速度区别,对于频繁需要切换AI模型的用户来说SSD绝对是标配。 |

手机版|外设堂

( 辽ICP备13014379号 ) 辽公网安备 21010202000549号

辽公网安备 21010202000549号

GMT+8, 2025-3-15 13:37 , Processed in 0.061157 second(s), 24 queries , Gzip On.

Powered by Discuz! X3.4

Copyright © 2001-2021, Tencent Cloud.